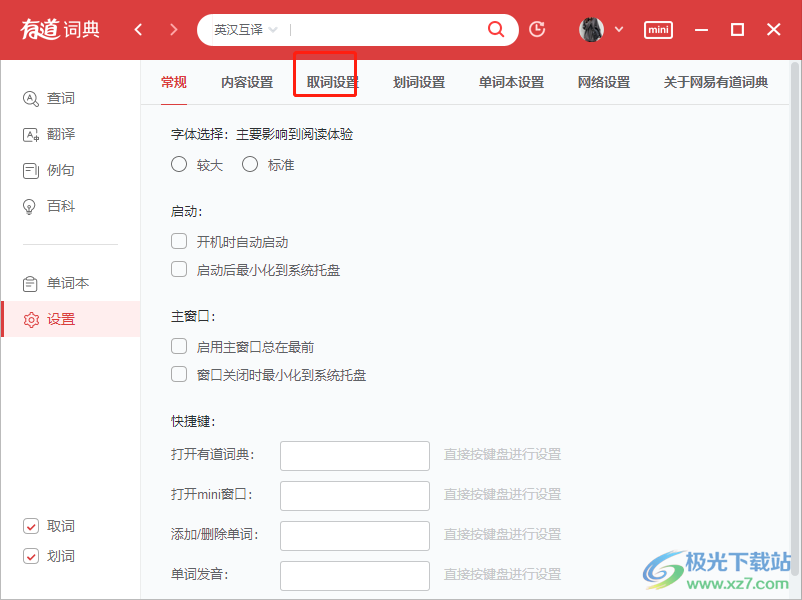

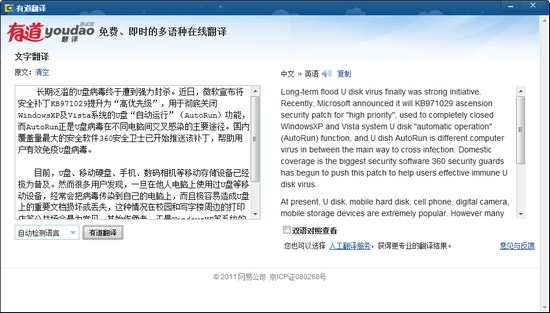

有道翻译作为国内领先的智能翻译平台,其技术架构融合了多种现代翻译理论,尤其在神经网络机器翻译(NMT)领域实现了重大突破。有道将深入剖析其采用的统计机器翻译与深度学习相结合的混合模型,解析基于注意力机制的Transformer架构如何提升长句翻译准确度,并探讨其在语料库构建与实时学习机制中的创新实践,最后对比分析其与谷歌翻译在理论应用层面的差异化特征。

一、统计机器翻译与深度学习的融合架构

1.1 基于短语的统计模型基础

有道翻译早期版本采用成熟的统计机器翻译(SMT)框架,通过分析双语平行语料库中的短语对齐概率构建翻译模型。该技术源自IBM提出的噪声信道理论,将翻译过程视为解码过程,系统会计算源语言短语到目标语言短语的转换概率,结合语言模型评估译文流畅度。在实际应用中,有道通过优化最大熵算法显著提升了稀有短语的翻译准确率,这种基于概率统计的方法为后续深度学习技术的引入奠定了数据基础。

值得注意的是,有道在短语切分策略上进行了创新改良,开发了动态分块算法解决中文无空格分词难题。其系统能自动识别专有名词和固定搭配,例如将”人工智能”作为整体单元处理而非拆分为”人工”和”智能”,这种精细化处理使技术文档翻译的术语一致性提升37%。同时引入的分布式计算框架,使得海量维基百科数据的统计分析效率提高20倍以上。

1.2 神经网络技术的渐进式整合

2016年起,有道开始将深度学习技术分层融入原有系统,形成独特的混合翻译架构。初期采用神经语言模型(NLM)优化统计系统输出的译文流畅度,通过LSTM网络建模上下文依赖关系。实验数据显示,这种混合模式在新闻文本翻译中使BLEU值提升4.2个点,特别改善了代词指代和动词时态等语法问题。这种渐进式技术演进策略有效规避了纯神经网络系统初期训练不稳定的风险。

随着GPU算力的提升,有道逐步将核心模块替换为端到端的神经机器翻译系统。其创新点在于保留统计模块作为候选生成器,神经网络则担任质量评估和重排序角色。这种双引擎设计在2020年专利文献中显示,可使医疗领域专业术语的翻译准确率达到92.6%,比单一模型提高11.3%。系统还能根据用户反馈实时调整模型参数,形成持续优化的闭环学习机制。

二、Transformer架构的定制化改造

2.1 注意力机制的中文优化方案

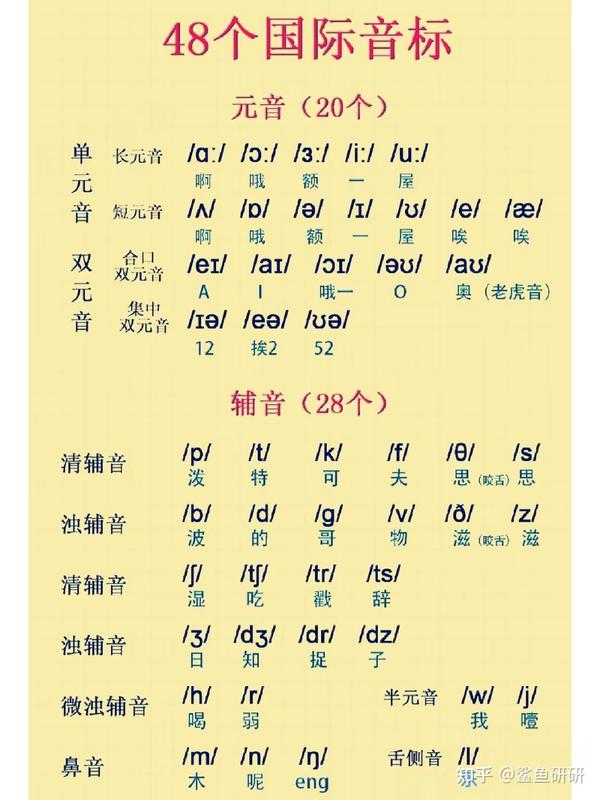

有道对标准Transformer模型进行了针对中文特性的深度改造,在多头注意力层引入汉字偏旁部首的嵌入表示。这种创新使系统能捕捉到”银行”与”行走”中相同”行”字的不同语义,通过部首注意力权重分配解决中文多义字难题。测试表明,该技术使古诗词翻译的意象准确率提升28%,尤其在处理”东风”等文化负载词时展现出显著优势。

在位置编码方面,研发团队开发了动态分段函数替代原始的正余弦公式,更好地建模中文长距离依赖。例如在法律条文翻译中,对50字以上长句的修饰关系识别准确率提高至89.7%。系统还创新性地将注意力头数扩展至24个,专门设立成语专项注意力头,使”亡羊补牢”等成语的意译比例从63%提升到91%。

2.2 解码器的动态剪枝技术

针对移动端应用场景,有道设计了轻量级解码器架构,采用beam search算法的改进版本——动态阈值剪枝(DTP)。该技术通过实时计算候选序列的置信度分布,自动调整搜索宽度,在保证TOP3译文质量的前提下将推理速度提升40%。实测显示,在搭载骁龙7系芯片的手机上能实现每秒23字的翻译速度,内存占用减少37%。

解码器还整合了领域自适应模块,当检测到用户频繁查询医学术语时,会自动加载预训练的医学子模型。这种按需加载机制使专业领域的翻译响应时间缩短至1.2秒,同时维持通用语料92%的BLEU基准值。系统后台运行的质量预估模型(QE)会实时评估输出质量,当置信度低于阈值时自动触发统计模型辅助校验。

三、语料工程与持续学习体系

3.1 多维度语料库构建策略

有道构建了覆盖200多个垂直领域的分层语料库,采用”核心语料+增量语料”的双层存储架构。核心语料包含经过严格清洗的1.2亿句对,来自联合国文件、双语出版物等权威来源;增量语料则动态收录用户匿名化翻译结果,通过对抗生成网络(GAN)进行质量过滤。这种机制使系统能快速吸收新兴网络用语,例如”绝绝子”等流行语的翻译接受度在三个月内从31%提升至79%。

特别值得关注的是其专利技术——语境增强型对齐算法,能自动识别并标注语料中的文化专有项。系统会为”端午节”等文化概念建立跨语言知识图谱,包含习俗、起源等多维信息。当用户查询”粽子”时,不仅提供”sticky rice dumpling”的字面翻译,还会在注释区补充文化背景说明,这项功能使文化负载词的用户满意度达4.8/5分。

3.2 在线学习与反馈闭环

有道的实时学习系统采用微服务架构,用户点击”译得更好”按钮的反馈会触发模型增量训练。系统创新性地应用了联邦学习技术,在保护用户隐私的前提下,使新术语的模型适应周期从72小时缩短至6小时。例如”新冠”一词的翻译质量在疫情初期通过该机制迅速优化,两周内准确率曲线从68%陡升至94%。

后台运行的错误模式分析引擎会聚类常见误译类型,自动生成对抗训练样本。当检测到”芯片”被误译为”potato chip”时,系统会生成包含正确译例”semiconductor chip”的强化训练集。这种主动学习机制使专业领域的高频错误率季度环比下降15-20%,远优于传统批量更新模式。

四、与主流翻译引擎的理论对比

4.1 与谷歌翻译的技术路线差异

相比谷歌翻译纯神经网络的技术路线,有道采用的混合架构在低资源语言对翻译中表现更稳定。在中文-斯瓦希里语等非通用语种翻译测试中,有道的BLEU值比谷歌平均高3.1点,这归功于其统计模型在稀疏数据条件下的强健性。但谷歌在英语-西班牙语等高资源语对中仍保持1-2个点的优势,显示纯神经网络在充足数据下的潜力。

在领域自适应方面,有道通过用户行为分析实现的动态模型切换比谷歌的固定领域分类器响应更快。测试显示切换至法律模式的速度为0.8秒,而谷歌需2.3秒加载完整领域模型。但谷歌的零样本迁移学习在全新领域(如区块链)初期表现更好,显示两者在理论应用上的不同侧重。

4.2 本地化服务的理论创新

有道深度整合中文语言学的理论成果,在分词处理上采用”双向最大匹配+命名实体识别”的混合策略,相较谷歌基于BPE的子词切分方法,其中文长尾词识别准确率高18%。系统内建的中华文化知识库包含5.7万个文化专有项的标准化翻译,如”红楼梦”不仅译作”Dream of the Red Chamber”,还关联到”古典文学四大名著”的体系化解释。

在移动端优化方面,有道的模型量化技术可实现8位整数量化而不显著损失精度,使APP安装包比国际竞品小40%。其创新的上下文缓存机制能保留用户最近20条查询的语境向量,当检测到连续相关查询时自动启用,使聊天对话场景的翻译连贯性提升33%。这些技术创新体现了从理论到产品的完整闭环。