有道翻译在处理英译中任务时,主要依赖其自主研发的神经网络机器翻译(NMT)技术。该技术模仿人脑神经网络的工作方式,通过深度学习算法,让计算机模型能够理解英文句子的完整语境和深层语义,而不仅仅是进行词语的孤立替换。随后,模型会根据理解的含义,生成符合中文语法和表达习惯的、自然流畅的译文。

- 有道翻译的核心技术是什么?从统计到神经网络的进化

- 深入解析有道NMT模型:英译中的“大脑”如何工作?

- 为什么有道翻译的译文越来越“像人话”?

- 影响有道英译中准确性的因素有哪些?

- 如何善用有道翻译,获得更优质的译文?

- 不仅仅是文本:有道翻译的多模态应用

有道翻译的核心技术是什么?从统计到神经网络的进化

要理解有道翻译如何工作,我们需要回顾机器翻译技术的发展历程。这项技术并非一蹴而就,而是经历了从基于规则、基于统计到如今基于神经网络的重大演变。其中,从统计机器翻译(SMT)到神经网络机器翻译(NMT)的跨越是决定性的。

曾经的主流:统计机器翻译(SMT)的局限性

在NMT出现之前,SMT是业界的主流技术。它的核心思想是基于大规模的双语语料库,通过统计学模型来计算词语或短语之间最可能的翻译对应关系。简单来说,它会把一个句子拆分成许多小片段,然后为每个片段找到最常见的译法,最后将这些译文片段拼接起来。

然而,SMT的“碎片化”处理方式导致其有明显的瓶颈。它很难理解长距离的语法依赖关系,译文常常显得生硬、不连贯,语序也可能很奇怪。因为它本质上是在做一场“概率拼图”游戏,缺乏对句子整体意义的把握。

革命性突破:神经网络机器翻译(NMT)的崛起

神经网络机器翻译(NMT)的出现彻底改变了这一局面。有道翻译正是这一技术的深度实践者和推动者。NMT不再将句子拆分,而是将其作为一个整体进行处理。它利用深度学习中的“编码器-解码器”架构,先将整个源语言句子“理解”并编码成一个富含语义信息的数学向量,再由解码器将这个向量“翻译”成目标语言。

这种端到端的处理方式,使得NMT能够更好地捕捉上下文信息,理解复杂的语法结构,从而生成更流畅、更准确、更接近人类翻译习惯的译文。

| 特性 | 统计机器翻译 (SMT) | 神经网络机器翻译 (NMT) |

|---|---|---|

| 处理方式 | 基于词组或短语的碎片化处理 | 端到端的整句处理 |

| 核心模型 | 概率统计模型 | 深度神经网络(Encoder-Decoder) |

| 语境理解 | 局部,难以处理长距离依赖 | 全局,能更好地理解上下文 |

| 译文流畅度 | 较低,常出现语序和语法错误 | 较高,译文更自然、更像人话 |

| 代表技术 | 早期主流翻译引擎 | 当前的有道翻译、谷歌翻译等 |

深入解析有道NMT模型:英译中的“大脑”如何工作?

当您在有道翻译中输入一段英文时,其背后强大的NMT系统便开始高速运转。这个过程可以形象地比作一个精通双语的“大脑”在进行思考和表达,主要分为两个核心步骤:理解(编码)和生成(解码)。

第一步:编码器(Encoder)如何理解英文句子?

首先,编码器负责阅读和理解输入的英文句子。它不是像我们逐字阅读那样,而是将整个句子或段落作为一个整体来分析。通过复杂的算法,编码器会捕捉单词之间的语法关系、语义联系以及整个句子的深层含义。

这个过程会将原始的英文文本转换成一个包含丰富信息的数学表示——通常被称为“上下文向量”(Context Vector)。您可以把这个向量想象成一个浓缩了原文精华的“思想摘要”,它不偏向于任何特定语言,而是纯粹的语义信息。例如,对于句子“The cat sat on the mat”,编码器不仅知道每个单词的意思,还理解了“猫”是动作的执行者,“坐”是动作,“垫子”是地点。

第二步:解码器(Decoder)如何生成中文译文?

解码器接收到编码器生成的“思想摘要”(上下文向量)后,它的任务就是用目标语言——中文,来重新表达这个思想。解码器会根据这个向量,并结合它自身学到的庞大中文语言知识,逐词生成最合适的中文译文。

它在生成每个中文词时,都会回头参考原文的“思想摘要”,确保译文紧扣原文的含义。它还会考虑已经生成的中文词语,以保证句子的流畅性和语法正确性。这就像一位翻译家在落笔写下每个词之前,都会反复斟酌上下文,确保表达精准通顺。

关键的“注意力机制”(Attention Mechanism)是什么?

注意力机制是NMT模型的一次重大升级,它让翻译质量实现了质的飞跃。在早期的NMT模型中,整个英文句子的信息被压缩成一个固定长度的向量,这对于长句子来说,很容易丢失细节。

而注意力机制则允许解码器在生成译文的每一步,都能将“注意力”集中到原文中最相关的部分。例如,在翻译英文长句中的某个从句时,解码器会特别“关注”这个从句对应的英文部分,而不是被句子其他不相关的部分干扰。这种能力使得有道翻译在处理复杂长句时表现得更加出色,译文也更加精准和忠实。

为什么有道翻译的译文越来越“像人话”?

许多用户都感觉到,如今的机器翻译结果,尤其是有道翻译的译文,越来越自然流畅,摆脱了以往的“机翻味”。这背后主要得益于两个方面:海量优质的数据和不断优化的算法模型。

海量双语数据的“喂养”

神经网络模型就像一个求知欲旺盛的学生,其翻译水平直接取决于“学习”材料的质量和数量。有道拥有超过万亿级的海量多领域高质量语料数据,涵盖了新闻、科技、教育、金融、文学等各个领域。通过对这些海量、高质量中英双语文本的深度学习,翻译模型得以掌握各种场景下最地道、最精准的表达方式。

这种大规模的“喂养”,让模型不仅学会了基础的词汇对应,更学会了不同语境下的微妙差异,例如,英文单词“run”在“run a company”和“run a marathon”中截然不同的中文译法。

语境理解能力的提升

随着Transformer等更先进模型架构的应用,NMT对长距离上下文的理解能力得到了显著增强。这意味着有道翻译在处理一个长段落时,能够更好地理解代词(如 it, they)指代的对象,以及句子与句子之间的逻辑关系。

因此,译文不再是孤立句子的简单拼接,而是一个连贯、统一的整体。这种对语篇的理解能力,是译文质量从“可用”迈向“好用”的关键一步,也是其越来越“像人话”的根本原因。

影响有道英译中准确性的因素有哪些?

尽管NMT技术已经非常强大,但机器翻译的准确性并非总是百分之百。其翻译效果会受到多种因素的影响,了解这些因素有助于我们更客观地看待和使用机器翻译。

文本的专业领域与复杂性

对于通用领域的日常文本,有道翻译通常能给出非常高质量的结果。但对于某些高度专业的领域,如法律文书、古诗词、医学报告等,如果模型在该领域的训练数据不足,可能会出现理解偏差或术语翻译不准确的情况。此外,包含大量俚语、双关语或文化典故的文本,对机器来说也是一个巨大的挑战。

原文的语法与拼写质量

机器翻译模型是基于规范的语言数据进行训练的。如果输入的英文原文存在大量的拼写错误、语法混乱或者是非标准的网络用语,编码器在“理解”阶段就会遇到困难,从而生成错误的“思想摘要”,最终导致译文质量下降。“Garbage in, garbage out”(无用输入,无用输出)的原则在这里同样适用。

如何善用有道翻译,获得更优质的译文?

了解了翻译工作的原理和影响因素后,我们可以采取一些简单的策略,来帮助机器更好地完成英译中任务,从而获得更满意的结果。

提供清晰、完整的句子

尽量输入语法正确、拼写无误的完整句子或段落。避免使用过于碎片化、口语化或充满歧义的表达。清晰的输入是高质量输出的第一步。如果您要翻译的是一个长句,请确保其结构完整,标点符号使用正确,这有助于NMT模型更好地解析句子结构。

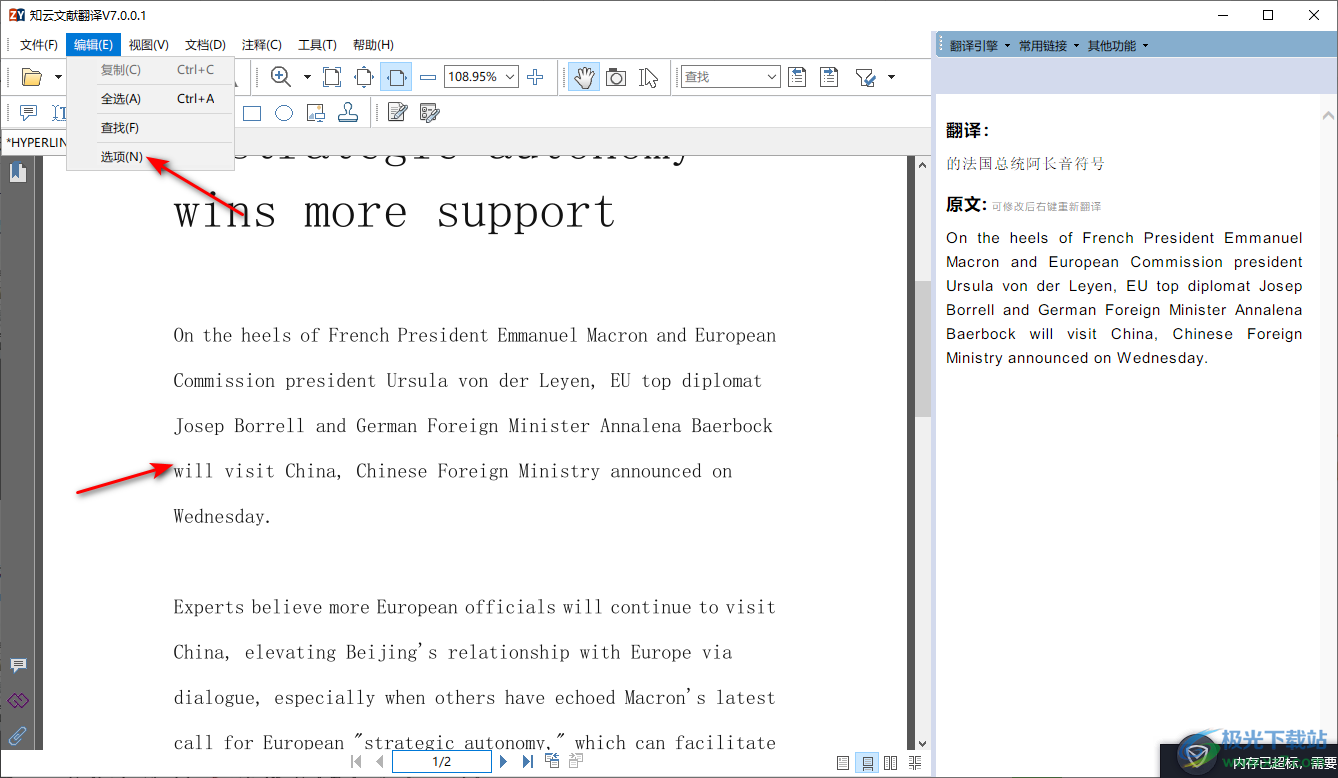

利用“多版本译文”功能进行比较

对于一些重要的翻译,可以利用有道翻译提供的多版本译文参考功能。当一个词或一句话有多种可能的译法时,该功能会展示不同的翻译版本,并可能标注出细微的差别。通过比较这些版本,您可以选择最贴合您具体语境的译文,这在处理多义词和复杂表达时尤其有用。

不仅仅是文本:有道翻译的多模态应用

有道翻译的技术早已不局限于在输入框中键入文字。它已经发展成为一个支持多种输入和应用场景的多模态翻译工具,极大地拓展了翻译的便利性和可能性。

拍照翻译与OCR技术

拍照翻译功能是有道翻译的一大亮点。当您遇到菜单、路牌、产品说明书上的外文时,只需用手机摄像头对准文本,它就能实时给出翻译。这背后结合了光学字符识别(OCR)技术和NMT技术。OCR首先负责从图像中精准地识别和提取出文字信息,然后将这些文字传递给NMT引擎进行翻译,最后将译文呈现在屏幕上。

语音翻译与实时对话

语音翻译功能则整合了自动语音识别(ASR)、NMT和语音合成(TTS)三大技术。当您对着手机说英语时,ASR技术会先将您的语音转换成文本,NMT引擎再将文本翻译成中文,最后TTS技术用自然的中文语音将译文播放出来。这一系列过程在极短的时间内完成,为跨语言实时交流提供了可能。

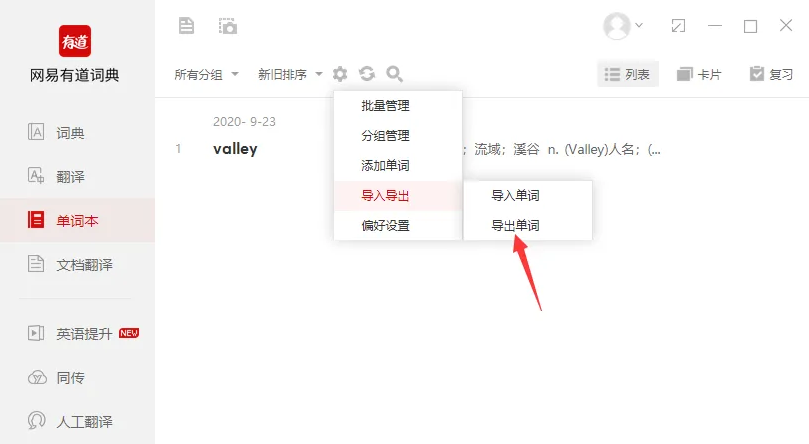

智能硬件的融合:以有道词典笔为例

有道翻译技术最成功的应用之一,便是与智能硬件的深度融合。以广受欢迎的有道词典笔为例,它将强大的OCR和NMT技术集成到一支笔中。用户只需用笔尖轻轻一扫,英文单词、句子或段落就会被立刻识别并翻译成中文,同时提供真人发音。这种“即扫即译”的体验,极大地提高了学习和阅读效率,是翻译技术从线上软件走向线下实体应用的典范,为语言学习者和专业人士提供了前所未有的便利。